W piątek miał miejsce “Tesla AI day”. Jego najgłośniejszym elementem była zapowiedź humanoidalnego robota. Trochę szkoda, bo w przeciwieństwie do większości ponad dwugodzinnego wydarzenia, istnieje on w zasadzie tylko na papierze, a reszta prezentacji traktowała o realnych dokonaniach i działaniach firmy.

Andrej Karpathy rozpoczął fragment poświęcony obróbce obrazu. Mówił, że to trochę jak budowa syntetycznego zwierzęcia od podstaw. Konkretnie chodzi o konstrukcję syntetycznej kory wzrokowej. To co może brzmieć prosto ale było dużym wyzwaniem, jest korzystanie z feedu z wielu kamer w jednej sieci neuronowej. Innymi słowy autopilot Tesli wpierw łączy dane z wielu kamer a dopiero później ma miejsce detekcja obiektów. Może wydawać się oczywiste, ale do tej pory trend był taki, że obraz z każdej kamery był procesowany osobno i dopiero potem łączony w model świata zewnętrznego dla maszyny.

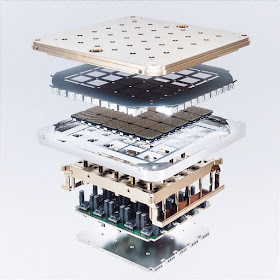

Kolejny duży i ciekawy fragment poświęcono architekturze komputera do nauki AI. W całości jest on zaprojektowany przez ekipę Tesli. W ogóle dość ciekawe, że Tesla robi i projektuje własną elektronikę. Ganesh Venkataramanan przeprowadził publiczność przez ich projekt od niemal najniższego poziomu.

Rozmiar podstawowego węzła obliczeniowego wyznaczono na podstawie tego jak daleko fizycznie jest w stanie dotrzeć sygnał w czasie jednego cyklu procesora a następnie obszar tej wielkości wypełniono elektroniką tworząc jednostkę o mocy obliczeniowej jednego TFLOPa (1012 operacji na sekundę). Jednostki te można łączyć dowolnie w płaszczyźnie. Robiąc właśnie to, tesla zrobiła plaster 354 takich “training nodes” i otoczyła je szyną wyjścia/wejścia (4TB/s). Tak wygląda “D1 Chip” z którego wyciskają 362 TFLOPy. Następnie z kolei połączyli 25 takich w “training tile” o mocy 9 PFLOPsów. To już zrobili. Jaki jast dalszy plan Tesli? Zbudować “ExaPoda” - superkomputer skonstruowany z 120 takich “uczących się kafelków”, o mocy jednego EksaFLOPa, czyli 1018 (tryliona) operacji na sekundę.

Pod względem mocy obliczeniowej byłaby to najsilniejsza maszyna na świecie. Obecnym liderem jest japoński Fugaku o mocy 500 PFLOPów, przy czym warto zwrócić uwagę, że wystarczy 40 PFLOPów żeby załapać się do górnej dziesiątki. ExaPod jest planowanym komputerem, ale pierwszy kafelek został już wyprodukowany i przetestowany, i już to stawia go w górnej setce. Ganesh Venkataramanan trzymał w rękach kafelek o mocy przekraczającej możliwości Poznańskiego Altaira (znajdującego się na 116 miejscu najmocniejszych superkomputerów na świecie). Daje to pewne poczucie skali. Aczkolwiek nie wiem czy ExaPod będzie pasował do tych rankingów, jako komputer dedykowany do nauczania sieci neuronowych.

Teraz możemy przejść do trzeciej, najbardziej medialnej części Tesla AI day. Prezentacja humanoidalnego robota zaczęła się od krótkiej animacji i... tanecznego występu faceta przebranego za robota. Nie będę opisywał poziomu mojego zażenowania, z ratunkiem przybył chyba podobnie zażenowany Elon, który w trakcie podziękował tańczącemu i wkroczył z również trochę obciachowym omówieniem planu Tesli by zbudować w pełni humanoidalnego robota.

Pomijając żarty o tym, że ma być bezpieczny ale na wszelki wypadek powinien być wolniejszy i słabszy od człowieka, intencje brzmią całkiem serio. I okoliczności też wydają się stosowne. W końcu cała ta prezentacja, może była nakierowana na AI do prowadzenia samochodu, ale biorąc pod uwagę stopień ogólności tych rozwiązań, dość oczywiste jest, że przeniesienie ich z kierownicy, gazu i hamulca na robota przypominającego człowieka powinno być naturalnym krokiem.

Biorąc pod uwagę to co robi Boston Dynamics, jak funkcjonuje Watson, jak sprawne stają się autonomiczne samochody, działające w oparciu o wizualne dane, można stwierdzić, że w zasadzie wszystkie elementy są już gotowe, “tylko” trzeba je połączyć. Tesla-boty (nie wiem czy dobrze zrozumiałem, ale ich robocza nazwa to “Optymista”) mają wykonywać prace nudne, powtarzalne i niebezpieczne. Idea jest taka, że z czasem będą w stanie poruszać się w ludzkim świecie, rozumieć polecenia słowne i robić wszystko to co ludzie. Elon stwierdził też, że w przyszłości praca fizyczna będzie wyborem i że uważa bezwarunkowy dochód podstawowy za równie nieunikniony.

Całość zakończyła długa seria całkiem sensownych pytań od publiki.

Całośc wydarzenia na youtube: www.youtube.com/watch?v=j0z4FweCy4M

"Biorąc pod uwagę (...) jak sprawne stają się autonomiczne samochody, działające w oparciu o wizualne dane, można stwierdzić, że w zasadzie wszystkie elementy są już gotowe, “tylko” trzeba je połączyć"

OdpowiedzUsuńBaardzo daleko posunięty optymizm, moim zdaniem. Taki "Full Self Drive" Tesli póki co jest nadal autopilotem level 2, w skali 1-5. Gdzie 1 to np... zwykły tempomat.

To chyba wiele mówi. Zresztą, samo używanie ww nazwy dla czegoś, co musi być, zgodnie z prawem, cały czas ręcznie kontrolowane, i co radzi sobie jako-tako może na autostradzie, bo już w mieście to średnio, a w Polsce - praktycznie w ogóle, jest sporym nadużyciem moim zdaniem, zwłaszcza biorąc pod uwagę cenę którą płaci klient za obietnice przyszłej autonomii.

A w ogóle, to uwierzę w nieodległą przyszłość wypełnioną przez autonomiczne samochody, gdy producenci zmierzą się z przejęciem odpowiedzialności prawnej za skutki działania algorytmu. Bo na razie, za wszystko odpowiada kierowca. Powodzenia.

Formalnie to może level 2, ale w praktyce wiadomo, że to bliżej levelu 4, ale trzeba przemielić to przez maszynkę prawną.

UsuńGdyby to sprzedawano jako l4, to by się firma nie wygrzebała z procesów o odszkodowania. No chyba że skłonią ustawodawców to takiej legislacji, że firma nie ponosi odpowiedzialności za skutki. Co w sumie nie jest całkiem wykluczone (wiadomo, wielkie korporacje mogą dużo), ale pożyjemy - zobaczymy.

UsuńMoże i roboty zastąpią ludzi, ale bynajmniej nie sądzę, żeby to implikowało konieczność dochodu podstawowego. Ot, będzie więcej slumsów, samobójstw i grabieży.

OdpowiedzUsuńI roboty-ochroniarze dla top 1promile :)

Usuń